برنامه پژوهشی علوم اجتماعی برای مطالعه تأثیرات تصمیمگیری الگوریتمیک

سمانه کوهستانی، جامعه شناس فرهنگی در سایت انگاره نوشت: «در حال حاضر هوش مصنوعی و ابزارهای تصمیمگیری الگوریتمیک بر بسیاری از ساحات زندگی ما تأثیر میگذارند و احتمالاً به طرز روزافزونی در کسبوکارها و دولتها استفاده خواهند شد. فردریک گِردون[۱] و فراوک کروتر[۲] با تکیه بر پژوهشها و نمونههای اخیر از حوزههای مختلف علوم اجتماعی، این موضوع را توضیح میدهند که کجا و چگونه علوم اجتماعی به استفاده اخلاقی از سیستمهای تصمیمگیری الگوریتمیک توجه میکند؟ و این مسئله تا چه حد ضروری است؟

ما مجبور نیستیم به آینده بنگریم تا نگران تأثیرات اجتماعی منفی سیستمهای مبتنی بر «هوش مصنوعی» باشیم. سیستمهای تصمیمگیری الگوریتمیک (ADM) در حال حاضر بر زندگی افراد تأثیر میگذارند و برای تصمیمگیری در حوزههای مختلف از عدالت کیفری و تأمین اعتبار تا تلاش برای شناسایی کلاهبرداریهای اجتماعی استفاده میشوند. درحالیکه این سیستمها میتوانند وظایف مختلف افراد را در روند کار وزندگی روزمره تسهیل کنند، پژوهشهای دانشگاهی و مطبوعات بارها بر اثرات نامطلوب اجتماعی را تأکید کردهاند. انتظار میرود این تأثیرات منفی با رواج بیشتر هوش مصنوعی افزایش یابد و اهمیت توجه به پیامدهای اجتماعی را نشان دهد. دانشمندان علوم اجتماعی به دلیل تخصصشان در طیفهای مختلف مسائل اجتماعی و روشهای گوناگون ارزیابی تأثیر، برای انجام پژوهش در خصوص چنین تأثیراتی، گزینههای بسیار مناسبی هستند.

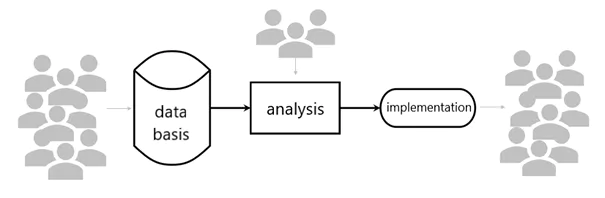

سیستمهای تصمیمگیری الگوریتمیک پیچیده هستند و بازیگران و فرایندهای مختلفی را دربرمیگیرند. بر اساس الگوی فرایند «دادههای کلان»، گردون و کروتر اخیراً فرایند ADM را بهصورت تحلیلی به سه بخش اصلی تقسیم کردند که نیاز به بررسی دارد (به شکل ۱ بنگرید):

شکل ۱: اجزای فرایند ADM بر اساس الگوی فرایند دادههای کلان پایگاه داده

۱- پایگاه داده بهکاررفته ۲- آمادهسازی و تجزیهوتحلیل دادهها و ۳- پیادهسازی واقعی سیستم و پیامدهای تصمیمات الگوریتم محور

هر یک از این مراحل دربرگیرنده تأثیرات اجتماعی ناعادلانه، تبعیضآمیز یا نامطلوب ناشی از سیستمهای َADM است. این منابع میتوانند از نقایص یا محدودیتهای فنی و مهمتر از همه، از تصمیمهای اخذشده توسط افراد که در این فرایند دخیل هستند، ناشی شوند. در ادامه، هر یک از این سه مخلفه ADM را بررسی و روشهایی را که علوم اجتماعی میتواند به این حوزه کمک کند، برجسته میکنیم.

دادهها بهعنوان منبعی برای الگوریتمهای آموزشی (یادگیری ماشین) به کار میروند. ازآنجاییکه این الگوریتمها برای پیشبینی افراد به دادهها متکی هستند، اطمینان از کیفیت بالای دادهها و انتخاب دادههای مناسب بسیار حائز اهمیت است. علوم اجتماعی بهطور خاص پژوهشهای پیمایشی، از پیشینهای نیرومند در بررسی کیفیت و سنجش و بازنمایی دادهها برخوردارند که بهطور خاص گروههای مختلف جمعیتی را شامل میشوند.

بااینوجود، حتی زمانی که کیفیت داده ازنظر تکنولوژیک بالا باشد، منبع داده ممکن است همچنان مشکلی ایجاد کند. این امر بهویژه زمانی صادق است که دادهها بازتابدهنده سوگیریهای ناعادلانهای باشند که در حال حاضر در جامعه متداول است. علوم اجتماعی در خصوص چنین سوگیریهای تاریخی (بهطور مثال، علیه گروههای جمعیتی خاص) از دانشی غالبی برخوردار است که به آن امکان میدهد در شناسایی و کاهش چنین سوگیریهایی مشارکت داشته باشد.

آمادهسازی و تجزیهوتحلیل دادهها

آمادهسازی دادهها بهمنظور تجزیهوتحلیل مستلزم اتخاذ تصمیمات متعدد در خصوص رمزگذاری مجدد، گروهبندی، حذف و سایر روشهای جایگزین در ارتباط با متغیرها و ارزشهاست. تصمیماتی از این قبیل میتوانند بر نتایج یک مطالعه تأثیر بگذارند. علاوه بر این، هنگام آموزش الگوریتم، تعیین اینکه چگونه الگوریتم باید به پیشبینیهای «عادلانه» دست یابد، حیاتی است. توسعهدهندگان یا تصمیمگیرندگان باید از میان دامنه گستردهای از تعاریف، تعریفی دردسترس و رایج از عدالت را انتخاب کنند تا اطمینان حاصل نمایند که الگوریتم به طرز نامتناسبی به گروه خاص (دموگرافیک) در مقایسه با سایر افراد آسیب وارد نمیکند.

انتخاب مناسبترین تعریف عدالت ممکن است به زمینه [اجتماعی] بستگی داشته باشد و همچنین باید دیدگاههای عمومی، یعنی افرادی که بالقوه تحت تأثیر چنین سیستمهایی قرار میگیرند، درنظر گرفته شوند. علوم اجتماعی میتواند از شناخت زمینههای اجتماعی و روشهای جمعآوری دادهها (همچون گروههای متمرکز، مصاحبههای کیفی و نظرسنجیهای کمی) برای بررسی و تحلیل هر دو نکته اخیر بهره گیرد.

پیادهسازی

بررسی تأثیرات واقعی تصمیمات بر فرد و گروههای اجتماعی هدفی بنیادین در قلمرو علوم اجتماعی است. در برخی موارد، تصمیمگیرندگان با پیشنهادها و توصیههای الگوریتمیک تعامل برقرار میکنند و دانش ناشی از پذیرش یا انکار موضوع را مهم جلوه میدهند، همانگونه که در زمینه تعامل انسان و رایانه مطالعاتی انجام شده است. علاوه بر این علوم اجتماعی میتواند چگونگی تأثیر سیستمهای تصمیمگیری الگوریتمیک (بهطور خاص مهم) را بر افراد و گروههای مختلف جامعه مطالعه کند و حتی قادر است از تکنیکهای شبیهسازی بهمنظور پیشبینی اینکه چگونه مجموعه تصمیمهای فردی کوچک میتوانند تأثیرات بزرگتری بر گروههای مختلف اجتماعی داشته باشند، بهره گیرد. همچنین، ارزیابی عملکرد و عادلانه بودن یک سیستم ADM در خصوص رویکردهای تصمیمگیری جایگزین (همانند تصمیمگیریهای انسانی بدون هیچگونه کمک الگوریتمیک) برای تصمیمگیری درباره موضوعی خاص، حیاتی است. شناسایی چنین اثرات علّی ADM در مقایسه با رویکردهای دیگر ممکن است مستلزم کار آزمایشی (که به لحاظ اخلاقی انجامشده) یا سایر طرحهای مطالعاتی پیچیده باشد.

مشارکت دانشمندان علوم اجتماعی بهمنظور توسعه و اجرای سیستمهای ADM (حیاتی) و ارزیابی تأثیرات منفی بالقوه آنها در جامعه امری بسیار مهم است. در این مطلب مواردی برجسته شدند که در آن دانشمندان علوم اجتماعی میتوانند با معرفت ذاتی و روشهای ویژه خود در شناسایی منابع بالقوه تأثیرات اجتماعی در فرایند ADM مشارکت نمایند. درحالیکه چنین پژوهشهایی در حال انجام است، صنعت و حوزه عمومی میتوانند از کاربرد علوم اجتماعی بهطورمعمول در توسعه و اجرای سیستمهای ADM سود برد. علاوه بر این، توجه به این نکته مهم است که مشارکت علوم اجتماعی در فرایند تصمیمات الگوریتمیک، استفاده از ADM را برای تصمیماتی که هرگز نباید توسط یک الگوریتم (بهتنهایی) اخذ شوند، توجیه نمیکند. بااینوجود، هنوز در حوزههایی که تصمیمگیری الگوریتمیک طبق اصول قابلقبول و منطقی به نظر میرسند، علوم اجتماعی قادر است به عادلانهتر کردن این سیستمها کمک کند.

جامعه از چنین مشارکتهایی سود میبرد و این مشارکتها نهتنها بهطور بالقوه وضعیت ناعادلانه را بیاهمیت میکنند، بلکه میتوانند پذیرش سیستم را افزایش دهند و درنتیجه به ما امکان دهند تا از تأثیرات مثبت تصمیمگیری الگوریتمیک بهتر بهره گیریم.

این مطلب برگرفته از مقاله تأثیرات اجتماعی تصمیمگیری الگوریتمیک، برنامهای پژوهشی برای علوم اجتماعی است که در فصلنامه Big Data and Society منتشرشده است.»

Gerdon, F., Bach, R., Kern, C., & Kreuter, F. (2022). Social impacts of algorithmic decision-making: A research agenda for the social sciences. Big Data & Society, ۹(۱), ۲۰۵۳۹۵۱۷۲۲۱۰۸۹۳.

[۱] Frederic Gerdon

[۲] Frauke Kreuter

انتهای پیام